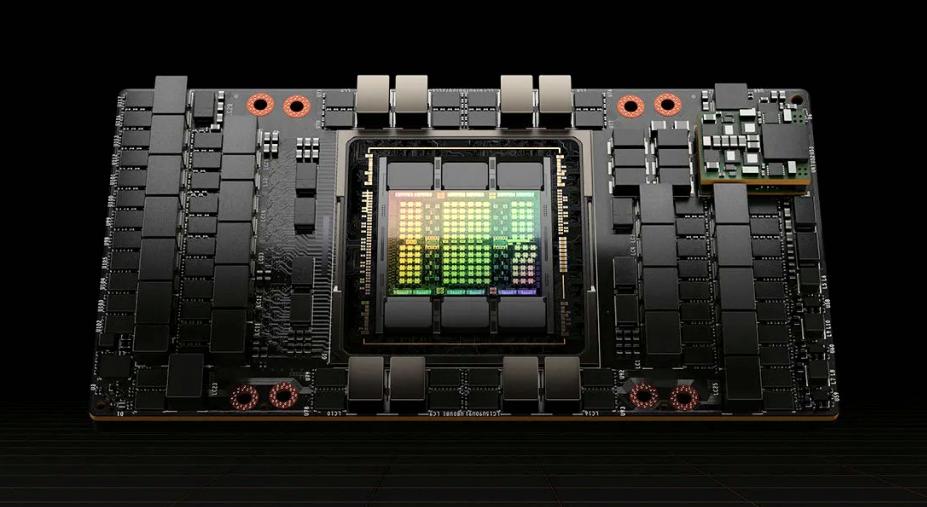

猿界算力了解到,H800是英伟达推出的一款特供版本,是英伟达为了符合美国出口标准,推出了A800和H800这两款带宽缩减版在我国大陆市场销售。美国GPU的出口禁令中规定主要限制了算力和带宽两个方面: 算力上限为4800 TOPS,带宽上限为600 GB/s。A800和H800的算力与原版相当,但带宽有所降低。

A800的带宽从A100的600GB/s降至400GB/s,H800的带宽仅为H100 (900 GB/s) 的约一半。执行相同的AI任务时,H800可能比H100多花费10%至30%的时间.英伟达H800是基于Hopper架构,对于大型AI语言基因组学、复杂数字计算等任务的效率提升模型、显著。

A100是英伟达推出的一款强大的数据中心GPU,采用全新的Ampere架构。它拥有高达6,912个CUDA核心和40GB的高速HBM2显存。A100还包括第二代NVLink技术,实现快速的GPU到GPU通信,提升大型模型的训练速度。

此外,A100还支持英伟达自主研发的Tensor Cores加速器,可提供高达20倍的深度学习性能提升。A100广泛应用于各种大规模AI训练和推理场景,包括自然语言处理、计算机视觉和语音识别等领域。

NVIDIA H800和A100是两款高端的GPU产品,下面是它们的参数对比:

除了参数方面的区别,两者在其他方面也有一些区别,以下是一些关键点:

1. 适用领域:英伟达A100和H800都适用于高性能计算、人工智能、深度学习等领域,但A100更适合大规模数据中心和云计算环境,而H800则更适用于个人和专业计算设备。

2. 性能:正如前面提到的,A100的算力高于H800,这意味着A100在处理复杂计算任务时更具有优势。

3. 能效:相较于H800,A100在能效方面有明显提升。A100采用了全新的Ampere架构,其Tensor核心在执行深度学习任务时能实现更高的能效。

4. 接口和兼容性:两者都支持PCIe接口,但A100还支持NVLink和InfiniBand等高速 interconnect技术,这使得A100在数据中心环境中具有更高的扩展性和性能。

5. 软件支持:英伟达为A100和H800提供了相同的软件生态系统,包括CUDA、TensorFlow、PyTorch等流行的人工智能框架。

租赁价格方面,H800比A100贵一些,毕竟各方面性能还是有差距的。H800目前月租金差不多在10万左右。

总的来说,英伟达H800和A100在算力、适用领域、性能、能效等方面有一定的区别。虽然H800在某些方面表现出色,但是A100依然是一个更加先进、更加强大的GPU产品,能够满足更高级别的计算需求。总之,具体选择哪款GPU,需根据实际应用场景和需求来判断。

猿界算力-GPU服务器租赁服务商

(点击下图进入算力租赁介绍页面)