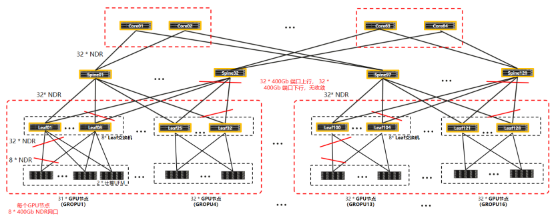

256台服务器已经是Spine-Leaf两层架构的极限了,超过256台就必须上三层架构,即:Core-Spine-Leaf三层架构。因此,今天介绍的512台H100的组网,我们是按三层IB网络考虑。在三层架构中,Core层作为核心交换层,负责高速数据的转发和汇聚;Spine层作为骨干网络层,提供高速的连接和转发能力;Leaf层则作为接入层,负责将服务器接入网络。

考虑到大模型训练对数据传输要求特别高,其中计算网络按全局无阻塞设计(no-blocking),采用 400Gb/s IB网络(NDR);存储网络采用 200Gb/s IB网络(HDR)。512集群的整体网络架构全图如下。

一、计算网络

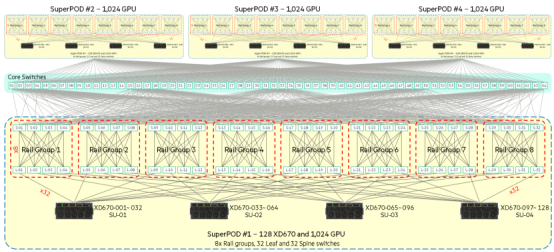

512台H100台服务器,分成4个SuperPod,每个SuperPod包含4个SU,每个SU包含32台H100服务器。也就是每个SuperPod有128台服务器。

每4台Leaf交换机+4台Spine交换机构成一个汇聚组(Rail Group),每个SuperPod对应8个Rail Group,即32台Leaf交换机+32台Spine交换机,对应Core核心层需要16台Core交换机。即每个SuperPod需要32+32+16=80台 IB交换机,4个SuperPod则需要80*4=320台IB交换机。

每台H100服务器配置8张400G网卡,采用多轨组网,即每台服务器的8张400G网卡分别连接到8台不同的Leaf交换机。

Core-Spine-Leaf三层组网拓扑图如下:

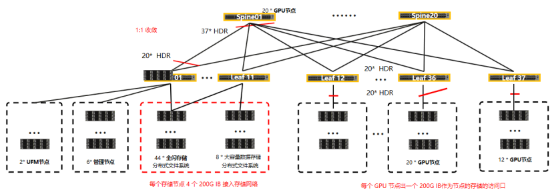

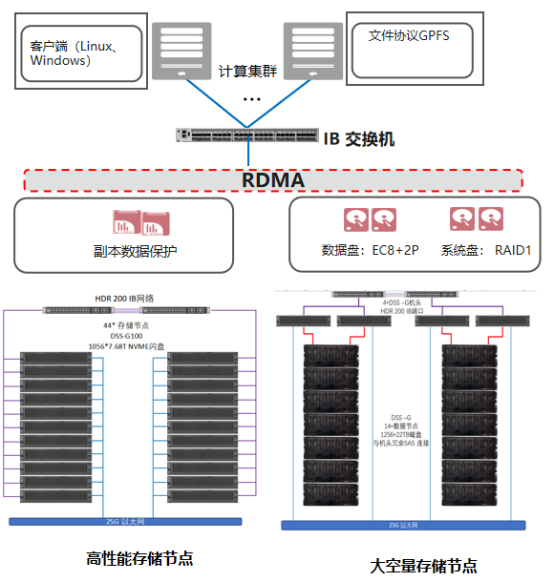

二、存储网络

512集群的存储系统分成两部分:高性能存储和大容量存储。高性能存储采用全闪硬盘,按1TB/GPU的配比配置,即512台H100服务器通常配置4PB高性能存储。大容量存储按高性能存储的4-5倍配置,按20PB可用容量规划。

存储网络采用 200Gb/s IB网络(HDR);每台H100服务器配置1张200Gb IB 网卡作为存储访问端口,整体网络采用Spine-Leaf两层组网,按全局 1:1 收敛比配置,需要37台Leaf 交换机和20台Spine 交换机,配置QM8700级别IB交换机即可。