InfiniBand详解

什么是InfiniBand?

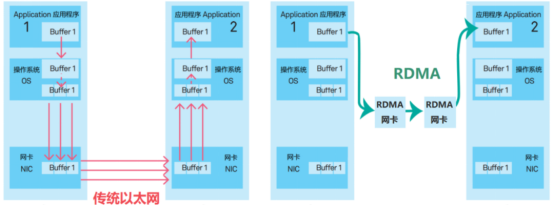

InfiniBand是一种高性能的网络通信技术,专为RDMA(Remote Direct Memory Access,远程直接内存访问)设计。它通过硬件级别的优化,实现了数据在服务器之间的高速、低延迟传输,极大地减轻了CPU的负担,提升了整体系统的性能。InfiniBand技术主要应用于高性能计算(HPC)和人工智能(AI)集群中,特别是在AI集群内进行分布式训练时,InfiniBand能够实现数据在服务器之间的高速传输,是构建高性能计算集群的关键技术之一。

InfiniBand的发展历程

诞生背景:上世纪90年代,随着计算机硬件的快速发展,PCI总线逐渐成为系统瓶颈。为了解决这个问题,IBTA(InfiniBand Trade Association)成立,研究新的替代技术,InfiniBand应运而生。

发展历程:

2000年,InfiniBand架构规范的1.0版本正式发布。

2003年,InfiniBand开始转向计算机集群互联。

2005年,InfiniBand又应用于存储设备连接。

2012年后,随着HPC需求的增长,InfiniBand技术不断发展,市场份额提升。

2015年,InfiniBand在TOP500榜单中的占比超过50%,成为超级计算机首选的集群互联技术。

主要厂商:Mellanox是InfiniBand市场的主要供应商,2019年被英伟达收购。

InfiniBand的网络带宽升级

InfiniBand的网络带宽经历了从SDR(Single Data Rate)、DDR(Double Data Rate)、QDR(Quad Data Rate)、FDR(Five Data Rate)、EDR(Enhanced Data Rate)到HDR(Hexa Data Rate)、NDR(Next Data Rate)的多次升级。每次升级都带来了网络带宽的大幅提升,从而支持更高速的数据传输。

InfiniBand组网

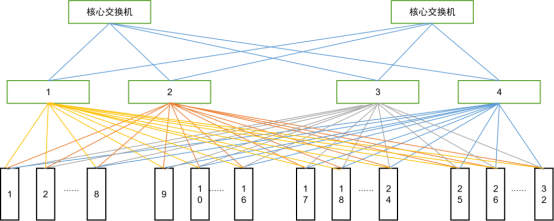

为了实现任何两个计算节点之间的无损通信,InfiniBand网络通常采用胖树网络架构。这种架构通过核心交换机和边缘交换机的组合,实现了高效的数据转发和接入。例如,一个包含32台H100服务器的典型InfiniBand网络拓扑图,展示了如何使用核心IB交换机和边缘IB交换机来构建网络。

InfiniBand商用产品

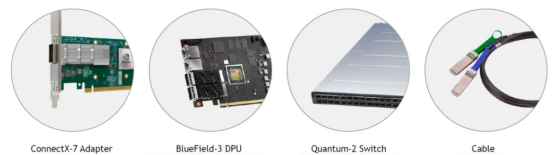

Mellanox(现为英伟达的一部分)是全球InfiniBand市场的主要供应商。其推出的第七代NVIDIA InfiniBand架构,包括NVIDIA Quantum-2系列交换机、NVIDIA ConnectX-7 InfiniBand适配器、BlueField-3 InfiniBand DPU以及专用的InfiniBand线缆。这些产品提供了高达51.2Tb/s的双向吞吐量,支持NDR 400Gb/s InfiniBand端口,是构建高性能计算集群的理想选择。

交换机:如QM9700和QM9790,提供64个NDR 400Gb/s InfiniBand端口或128个200Gb/s端口。

适配器:如ConnectX-7,用于服务器与InfiniBand网络的连接。

线缆:包括DAC高速铜缆(传输距离短,价格相对便宜)和AOC有源光缆(传输距离长,价格较高)。

综上所述,InfiniBand作为一种高性能的网络通信技术,在高性能计算和人工智能领域发挥着重要作用。通过不断的技术升级和商用产品的推出,InfiniBand将继续为构建高效、稳定的算力网络提供支持。